개요

먼저 robots.txt가 무엇이고 왜 필요한지를 간략하게 알 필요가 있습니다. 왜냐하면 그래야 원리가 이해가 되고 응용이 가능하기 때문입니다. 무턱대고 여기저기서 찾은 정보대로 따라하기만 하면, 결국에는 아주 간단한 문제조차 스스로 해결할 수 없게 되기 때문입니다.

robots.txt는 무엇인가?

이것은 자기 웹/앱 사이트를 방문하는 로봇(검색로봇 등)들과 서로 대화를 통해 그 방문 로봇들을 제어하기 위한 것입니다. 그것들에게 "여기는 색인하면 안된다" 라든가 "여기는 중요한 곳이니 SEO에 맞게 더 신경써서 색인해달라"와 같은 차단이나 요청 등의 일을 합니다. 그러나 robots.txt는 통신 수단일 뿐 강제 수단이 아닙니다. 그러다 보니 이런 요청을 무시하는 '악성 봇'들의 나쁜 행위들을 막아주는 역할을 할 수는 없습니다.

방법

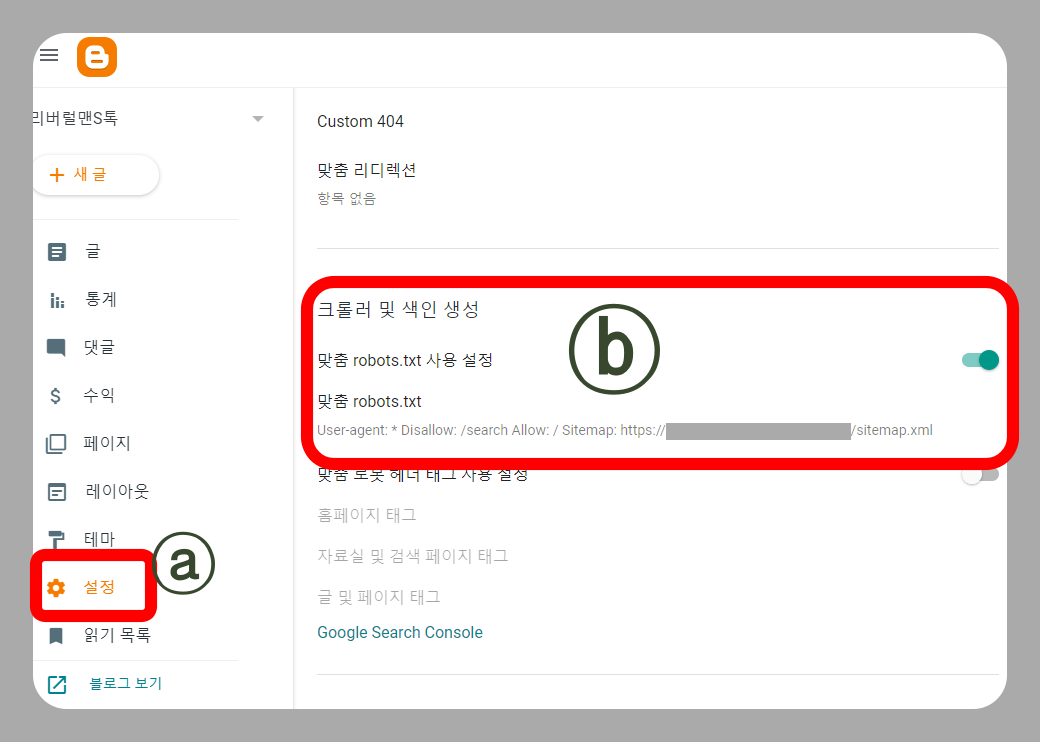

1) 왼쪽 사이드바에서 '설정 (아래그림에서 붉은 사각형 'a')' 메뉴에 들어 갑니다.

2) 들어가서 나오는 오른쪽 화면에서 '크롤러 및 색인 생성' 부분을 찾은 뒤 (붉은 사각형 'b')

3) '맞춤 robots.txt 사용설정' 메뉴를 'ON' 시킨 다음 (버튼이 파란색이 되면 ON입니다)

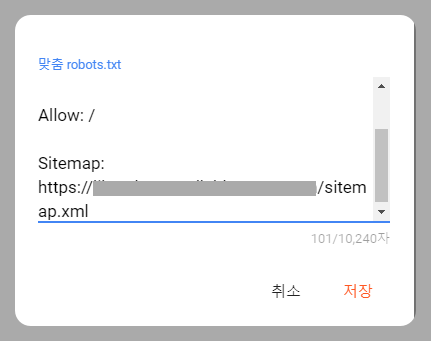

4) 그 아래 '맞춤 robots.txt' 메뉴를 클릭하여 나오는 입력창에 (아래 그림 참고) 다음과 같이 입력합니다.

User-agent: *

Allow: /

- URL 내의 모든 페이지를 모든 로봇에 대하여 색인을 허용하겠다는 뜻 sitemap 정보는 써도 되고 안써도 됩니다.

결론

위에 적은 내용은 특별한 구애됨이 없이 방문 로봇에게 자기 URL내의 모든 페이지를 다 공개하겠다는 뜻입니다. 이렇게 단순하게 등록하지 않고, 더 많은 기능을 사용하여 다양한 성능을 내려면 더 많이 복잡합니다. 그러나 여기서는 그런 내용을 다루지 않고 단순히 등록하는 방법만 말씀 드립니다.

'etc > 블로그 테크닉' 카테고리의 다른 글

| STOVE (스마일 게이트 게임 커뮤니티) 해외접속 차단하는 법 (0) | 2024.09.15 |

|---|---|

| 구글 서치콘솔에서 소유권(ownership)을 재확인 하는 방법 (1) | 2024.09.15 |

| 네이버 블로그 이웃 차단, 사용자 차단 하는 방법 (8) | 2024.09.15 |

| 애드센스에 새로 추가한 구글블로그에 '광고'가 올라오지 않을 때 (6) | 2024.09.13 |

| 네이버 블로그, 티스토리, 구글 블로그 에서 이미지에 걸린 링크를 삭제하는 방법 (0) | 2024.09.13 |